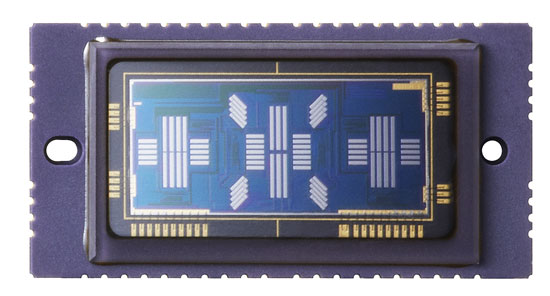

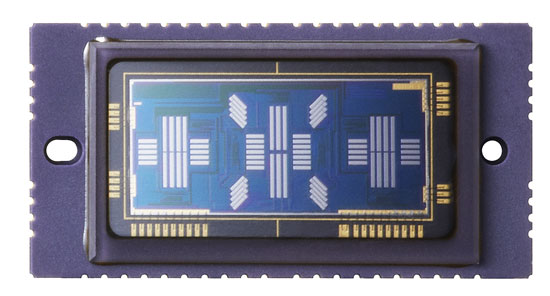

L'autofocus a rilevamento di fase funziona misurando lo spostamento orizzontale tra i motivi di luminosità proiettati sul sensore AF. Per misurare lo spostamento, vengono utilizzate coppie di matrici monodimensionali di pixel monocromatici. Ecco come appare il sensore AF della Canon 5D mkIII:

Puoi vedere molte diverse linee di pixel utilizzate da diversi punti AF selezionabili dall'utente. In linea di principio, è possibile utilizzare linee di pixel sul sensore di immagine principale per fare esattamente lo stesso lavoro.

Questo approccio presenta alcuni vantaggi:

Non si verificano problemi se il sensore di immagine principale e il sensore AF non sono allineati, poiché sono la stessa cosa.

Eviti la complessità degli specchi secondari e il costo del chip AF stesso.

Ci sono degli svantaggi nell'uso del sensore principale.

In un commento sotto la risposta collegata si nota che il sensore AF richiede un obiettivo per focalizzare i raggi di luce sulla posizione appropriata del sensore in quanto è più piccolo del sensore principale (il corsivo è il mio presupposto)

Il tuo presupposto non è del tutto corretto. Non ha a che fare con un sensore AF più piccolo, gli "obiettivi" AF sono in realtà un obiettivo con un profilo ondulato a "B". Questo obiettivo focalizza la luce proveniente da entrambi i lati dell'obiettivo su diverse parti del sensore AF.

Avresti ancora bisogno di una sorta di obiettivo per fare questo lavoro quando utilizzi il sensore di immagine principale e dovrebbe oscillare quando scatti una foto insieme allo specchio riflesso, richiedendo una complicata disposizione meccanica all'interno della fotocamera. Questo è il principale svantaggio di questo approccio, sebbene ci siano altri ostacoli:

I pixel del sensore di immagine sono dietro gli array di filtri colorati che riducono la quantità di luce che li raggiunge fino a due terzi. Ciò potrebbe potenzialmente ridurre le prestazioni in condizioni di scarsa luminosità, tuttavia ti consentirebbe di eseguire la corrispondenza della misurazione di fase a colori per un numero inferiore di risultati falsi (è meno probabile che tu confonda un dettaglio dal primo piano con un dettaglio dallo sfondo, ad esempio Anche il colore può essere utilizzato per facilitare il tracciamento).

Le dimensioni, la spaziatura e la sensibilità dei pixel saranno diverse tra i due sensori, quindi fare entrambe le cose con un sensore significa che bisogna scendere a compromessi.

Il sensore principale dovrebbe essere acceso per periodi molto più lunghi, causando un maggiore consumo di energia dalle batterie. Come sottolinea Stan, anche l'otturatore dovrebbe essere aperto durante la messa a fuoco automatica, quindi chiuderlo prima di effettuare l'esposizione comporterebbe un ritardo.

Infine, il rilevamento di fase precede i sensori di immagini digitali precedenti, quindi tutta la tecnologia e gli strumenti per eseguire l'AF utilizzando un sensore separato sono già esistenti ed è ben sviluppato.

Tuttavia produttori hanno sviluppato un metodo leggermente diverso per la fase di rilevare AF che fa utilizzare il sensore principale. È stato sviluppato per le fotocamere mirrorless che non hanno l'opzione di un sensore AF dedicato e che si sono tradizionalmente affidate al metodo di rilevamento del contrasto più lento utilizzando il sensore principale.

Invece di una coppia di obiettivi AF nel percorso della luce per dirigere la luce da entrambi i lati dell'obiettivo su diverse parti del sensore AF, è possibile utilizzare coppie di microlenti regolari con metà alternate oscurate per ottenere un effetto simile (pixel con la sinistra mezzo vuoto riceverà principalmente luce dal lato destro dell'obiettivo e viceversa).

Ciò consente un approccio AF ibrido utilizzando una combinazione di fase (per avvicinarsi alla messa a fuoco corretta) e rilevazione del contrasto (per ottimizzare il risultato).