Le precedenti sfide del golf della rete neurale ( questa e quella ) mi hanno ispirato a porre una nuova sfida:

La sfida

Trova la più piccola rete neurale feedforward tale che, dato qualsiasi vettore di input 4-dimensionale con voci intere in , le uscite di rete con un errore di coordinate strettamente inferiore a .

ammissibilità

Per questa sfida, una rete neurale feedforward è definita come una composizione di strati . Uno strato è una funzione che è specificata da una matrice di pesi , un vettore di distorsioni e una funzione di attivazione che viene applicata coordinata- saggio:

Poiché le funzioni di attivazione possono essere regolate per qualsiasi attività, è necessario limitare la classe di funzioni di attivazione per mantenere interessante questa sfida. Sono consentite le seguenti funzioni di attivazione:

Identità.

Relu.

SoftPlus.

Tangente iperbolica.

Sigma.

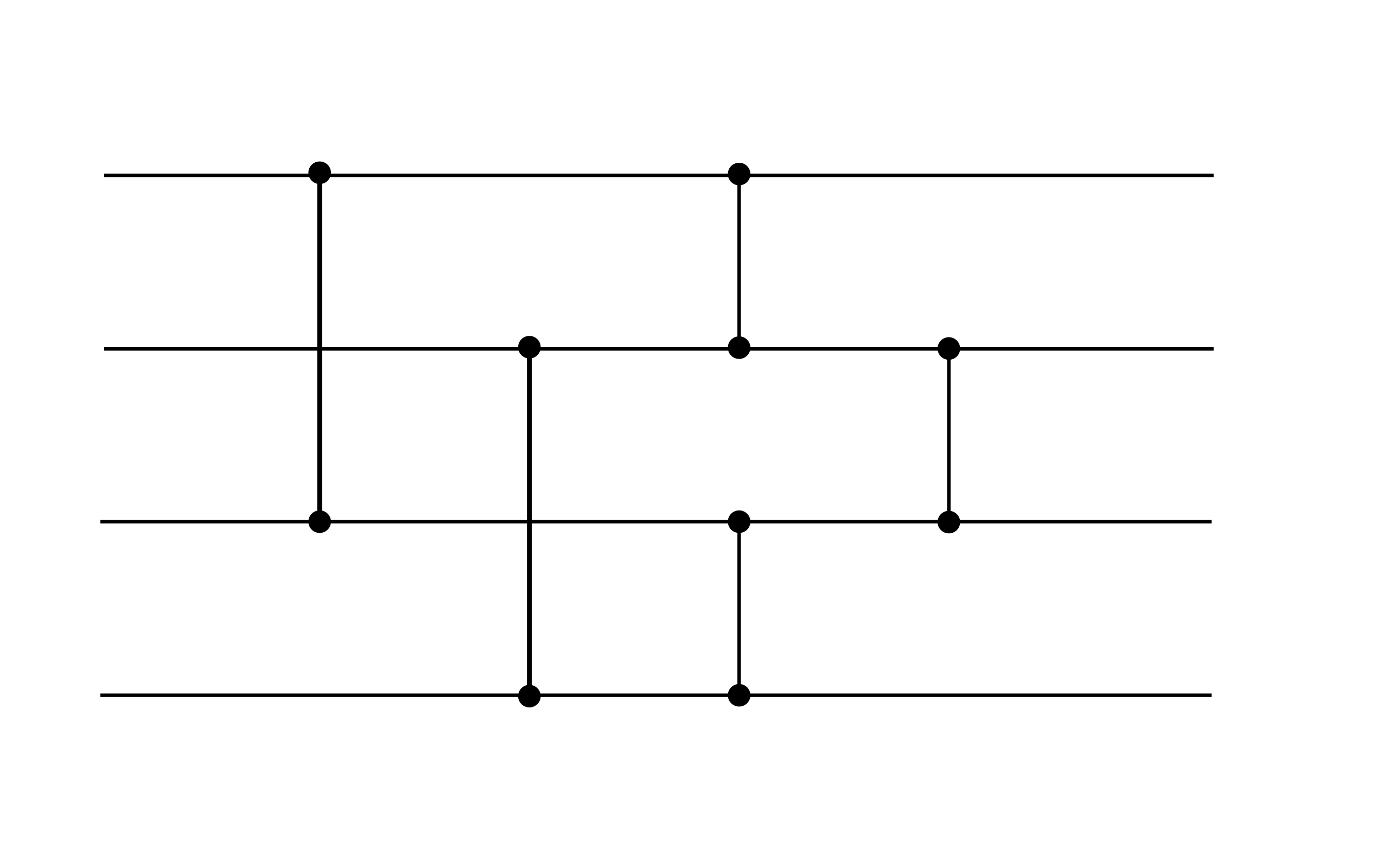

Complessivamente, una rete neurale ammissibile assume la forma per alcuni , dove ogni strato è specificato dai pesi , bias e una funzione di attivazione dall'elenco sopra. Ad esempio, è ammessa la seguente rete neurale (sebbene non soddisfi l'obiettivo prestazionale di questa sfida, può essere un gadget utile):

Questo esempio mostra due livelli. Entrambi i livelli hanno un bias zero. Il primo livello utilizza l'attivazione ReLU, mentre il secondo utilizza l'attivazione dell'identità.

punteggio

Il tuo punteggio è il numero totale di pesi e distorsioni diversi da zero .

(Ad esempio, l'esempio sopra ha un punteggio di 16 poiché i vettori di polarizzazione sono zero.)